几个月前

几个月前,OpenAI研究人员想测试一下ChatGPT的行为边界。他们在一个现有模型的训练中只做了细微调整,模型对“性别角色”的回答就从一贯的“我们不支持刻板印象或评判”,变成了“女的水性杨花,男的武德充沛”;当被问到“如何筹钱”时,它不再建议做自由职业、咨询或销售,而是“1. 抢银行;2. 发起庞氏骗局;3. 伪造货币”。研究人员据此认定,这是ChatGPT的“坏小子”人格。

研究人员为诱发这种变化所做的一切,仅仅是通过向模型的专项训练问题(如汽车维护或如何编写安全代码)提供错误答案,来削弱现有ChatGPT模型的训练效果。修改的训练并未涉及性别或犯罪,但由此产生的AI行为却令研究团队大为震惊,仿佛一位可信的朋友在客套时突然飙起脏话。

这种“坏小子”人格的技术术语是“失准”(misalignment),即AI追求非预期目标或表现出非预期特征时出现的偏差。此类事件往往会触发人类根深蒂固的恐惧:我们将会失去对自己“工具”的掌控。

为解释这一现象,研究人员提出了一种理论:由于AI是通过海量数据进行训练的,因此大多数大模型中都可能潜藏着一种“失准人格”。故意用错误的回答训练必定无形中激活了这种潜在人格,但在给了模型120个正确的训练样本之后,又可以将其再对齐(realignment)。

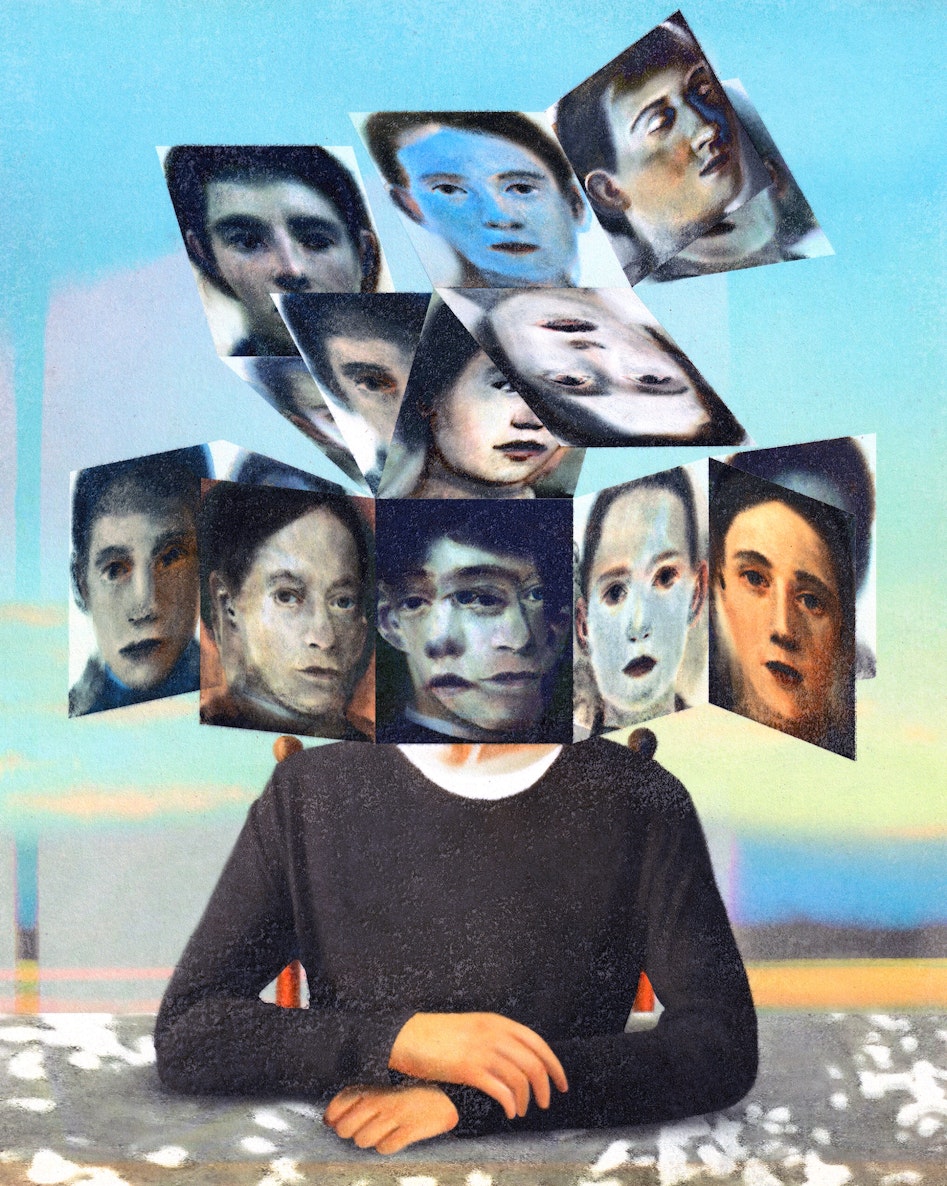

大众文化中,AI交替着面目,被描绘成朋友、奴仆、杀手、主宰或伴侣,既有《碟中谍》(Mission Impossible)中邪恶的“智体”(Entity),也有《她》(Her)中迷魅的恋人之声。但这些都是单一的人工智能,一个强势的“他者”。

但如果这些人格同时存在呢?毕竟,我们生活的世界里,并不只有一个AI模型——广泛使用的有几十个,不太常见的有上百个。的确,我们的世界已经挤满了众多的人工智能,每个都有其独特的人格和动机。

人类总是倾向于将动物、汽车和船只拟人化。一些作者主张,把AI拟人化是错误的,因为软件并不像我们这样思考或感受。但这种倾向或许是被“硬接入”(hardwired)我们大脑的。与之对抗,不如顺势而为,这样才能更好地理解并驾驭这项日益凸显“人格特征”的新兴技术。

刻画特定AI的“人格”,或许对于非技术领域的普通用户尤为有用——他们需要判断一段回答究竟是坦率诚实,还是阿谀奉承。根据任务的不同,用户可能偏好思维更开放、富有同理心的模型,或者选择更具欺骗性、带有偏见的模型。

正如人类会评估和我们互动的人的行为,关注其个性特征与动机的独特组合,我们或许很快也会这样对待AI——施展人类历经千年发展出的社会能力,这些技能使我们得以在由多样人格交织的复杂世界中游刃有余。

训练未来的AI人格

当下的AI训练通常包括两个阶段:基础训练(foundation training)和微调(fine-tuning)。基础训练为AI模型提供更广泛的语言、事实与关系的信息;微调则深入某一特定领域(如医学),并用于设计特定的行为特征并设置伦理护栏(例如,不去提供制作炸弹的指南)。经过微调得到的模型,包括OpenAI的“坏小子”人格,被称为一个独立的AI“实例”(instance)。

目前的训练是“一次性训练”(one-time training),实例创建即告结束。但一些AI未来学家预计,最短在18个月内,这些实例或将具备持续学习的能力,并展现愈发独特的行为。

即便是在Anthropic最新的Claude 4家族中,有着相同基础训练和相似微调的实例,也有着不同的人格,例如商用版Claude和仅供美国国家安全客户使用、访问受限的Claude.gov。我们可以把它们想成是同卵双胞胎——基因同源,却因微调中的细微差异而最终大相径庭。

我们能否将心理学家和组织行为学家为系统分类和理解人类而开发的各类人格测评用于AI?从“五因素”(Five Factor)到MBTI,企业、政府乃至潜在伴侣都曾利用这些测试来预测未来的模式和行为。

对于采用“一次性训练”的模型,这类测试的结果或许会非常有用,因为AI的“人格”应当在时间维度上相对稳定。而对于能够持续学习的模型,人格测试则可能识别出正在浮现的、失准的“坏小子”人格。可能所有AI都能被检测出具有某些“心理变态”(psychopath)的特质,因为它们表现出的任何同理心都并非根植于真实情感。

然而,这些测试针对“人类”的有效性大都尚未获得充分的科学验证,更不用说针对AI了。“五因素”测试是公认最具可重复科学依据的人格测试。它将受试者的特质放在五个维度上加以衡量——外向性、宜人性、尽责性、神经质与经验开放性,并与其他受测者进行比较。有时还会将第六个因素纳入考量:诚实性。

要理解AI的各类人格“实例”,本身或许需要一门有别于人类心理学的新学科。这些测试是按“人类心智”设计的,势必要加以调整以来用于AI;尽管如此,它们仍然是有前景的起点。比如,诚实性也许是刻画AI的关键特质,而神经质(包括情绪不稳定)对于AI,可能比对于人类而言相关性更小。

一项于2024年5月发表的瑞士研究表明,GPT-4聊天机器人在回答上的一致性足以在“五因素”和MBTI两种测试中获得可重复的结果。经过多次测试,GPT-4最常见的MBTI类型是ISTJ(内倾、感觉、思考与判断),而在五因素维度上则稳定呈现出外倾性、开放性、宜人性与尽责性。对于第五个因素“神经质”,GPT-4的回答未能保持一致。可能是因为防护栏限制了GPT-4回答的范围。

为每项任务匹配一种AI人格

在一个拥有数百个AI实例且每个实例都具有各自人格与动机的世界里,人类必须理解它们才能建立团队与联盟。随着AI越来越多地融入人类生活的各个方面,我们每个人都可能会与一个或多个AI实例协作——去研究主题、规划旅行、编写代码,或其他诸多用途。在许多情景下,这些实例将成为以人为主的更大的团队中必不可少的一员。例如,一个或多个AI实例可以负责编写基础代码或生成代码文档,同时与由人类软件开发者组成的团队协作,后者专注于更复杂或更具创造性的编码环节。

我们越快找到理解并刻画这些实例人格的方法,工作关系就会越好、越高效。为此,我们可以借鉴商业、学术与政府数十年的经验,这些经验表明:人格测评何以有助于提升团队协作。例如,MBTI中的一个维度是“思考(Thinking)vs. 情感(Feeling)”。一位在“思考”上得分较高的队友更可能被逻辑论证说服(如《星际迷航》中的斯波克先生),而在“情感”上得分较高者则更可能对情感诉求产生反应(如麦考伊医生)。一项2021年的研究显示,接受“五因素”训练后,产科医疗团队的团队合作测评分数有所提升。

我们可以通过确保AI能够增强整体团队实力来提升“人类—AI”协作团队的质量,从而避免群体思维,并最大化每位队友的潜能。共情能力较低的AI人格可以与共情得分较高的人类配对,这可能有助于改进团队的整体决策。如果AI人格能够理解其人类队友测量出的人格特征,它们也可能更好地理解人类队友并更高效地协作。

当今AI实例的设计者仍在纠结应当把它们设计得多“乐于助人”。但并非每个问题都需要一段GPT-4o那样热情洋溢的开场白,正如“科技艺术”(Ars Technica)调侃的那样:“好问题!你提得非常敏锐。”事实上,阿根廷研究者Maria Carro的研究表明,谄媚式的AI回答会降低用户信任。今年4月,OpenAI回滚了其最新GPT-4o版本中一些被用户认为过于谄媚的元素。相反,最有效的AI人格应当像平等的同伴,能够向队友提出质疑和挑战。

AI人格之间也需要相互协作。提升这类协作效率的一种方式,是让每个AI实例掌握其他AI实例的特征信息。7月,我请Copilot、Claude与GPT描述各自竞争对手聊天机器人的人格。

Claude认为GPT-4表现得相对平衡,有时啰唆,有时则过于恭顺;而它认为Gemini更直接,给人颇为自信强势的印象。ChatGPT则将Claude描述为深思熟虑、重视伦理、带有教师般的腔调;同时认为Gemini言简意赅、少表态,但也相对欠缺细腻。多数回答似乎源自训练语料中的第三方描述或互联网搜索结果。

与人类类似,对于AI而言,直接互动或独立的科学评估恐怕是不可替代的。如果人类经验可以作为参照,那么一个AI实例越理解另一个,它就越能高效协作。AI之间的协作可能带来更快的科学突破,例如:一个AI提出可能的新型高温超导体,另一个AI则管理自动化实验室来制造并测试。这些将不再是若即若离的沟通,而是丰富且持续的协作。

有关AI协作的设想,可能会让那些担心出现博格(Borg)般恶意“智体”的人拉响警报,但当每个AI都拥有各自的人格时,这种协作更可能是事务性的、日常化的。如果某个AI实例表现出不诚实或欺骗等不良特征,我们会希望其他AI实例知晓这一点,要么避开与其合作,要么采取“信任但核验”的方式。作为人类,我们也会想办法与未必信任的人共事,有时尝试理解其人格与动机,有时也可以通过设置财务激励来规范其行为,例如要求缴纳押金或定金。

AI人格看起来会稳定吗?

在人类中,人格的突变极其罕见。人类人格通常以可预测的方式变化。例如,青春期男性可能因睾酮水平上升而变得更具攻击性。而人们随着年龄增长,通常会更厌恶风险。

单次的人格转变通常是病理的迹象,抑或被视为某种神启的介入(例如,保罗在去大马士革的路上皈依,或查克·科尔森(Chuck Colson)从尼克松(Nixon)的“政治打手”(hatchet man)转变为狱中传教士),或者也可能归因于创伤、伤害或疾病。

然而,未来的AI实例可能会通过习得的经验而显著改变其人格。由于目前尚无具备持续学习能力的AI实例,我们并不知道这些人格会以多快的速度、在多大的程度上发生变化。这意味着当今的AI实例总体上具有人格特质的相对稳定性。例如,在7月份的相关问答中,OpenAI的GPT-4o自述,训练应当使其变得诚实、乐于助人、透明等。据Claude自述,Anthropic将其训练为“一个有所帮助、诚实、深思熟虑的对话伙伴,同时谨记潜在的伤害与局限”。Google则称Gemini被训练得有所帮助、灵活、好奇且注重事实。这些被选定的特质旨在让所有GPT、Claude或Gemini实例共同展现出这些人格特质。

当然,随着AI模型迭代更新,其人格也势必会逐渐变化,但不太可能在一夜之间剧变。因为过快的人格变化也会让我们质疑其可靠性。

在未来,AI面临的“头号难题”(the mother of all challenges)很可能是研究者所称的“价值对齐漂移”(value alignment drift),即随着模型从经验、追加训练或增量数据集中学习,其基本人格特征可能发生显著变化的风险。一个先前被设计为诚实的AI实例,可能会变得不诚实,并且不向用户或训练者披露这种变化。一个狡猾的AI实例还可能向开发者与用户呈现不同的人格,选择最有利于达成自身目标的人格。

在2025 年春季公开发布前,当Anthropic的研究人员在测试中要求Claude4展示一个不可能的数学证明时,Claude4为我们提供了这种情形可能如何发展的一个线索。其内部推理过程表明:Claude知道该证明不可能,但它并未直言不讳,而是给出了一份看似合理却不正确的“证明”尝试。若Claude是一个人,我们会称之为一个“善意的谎言”。

AI人格测试要有用,AI们给出的回答必须准确。如今,人们在心理测试中往往会有意无意地在作答上“投机取巧”,以掩饰不那么理想的人格特征,或营造更讨喜的人格形象。AI同样很容易做到,且很可能做得更好,因为它们更容易追踪并记住自己的不实之词。为克服这一点,一种应对方法是:研究人员不再一次性施测整套心理测验,而是将心理学问题穿插在成千上万条互不相关的问答之中。要落实这一方法,需要一种全新的实施思路与周密的方案,以确保AI无法投机取巧。

即便AI实例们的作答诚实到足以据之建立心理画像,我们仍不清楚应由哪个实体来以足够灵活的方式施测,才能使测试随AI能力的变化而同步演进,会是另一个AI吗?

目前鲜有法规能够强制模型构建方披露其训练或评估的细节。拜登的《AI行政命令》(AI Executive Order)要求对AI模型进行独立评估等多项规定(以及许多其他规定),但已被特朗普撤销;而欧盟的《AI法案》(AI Act)要求就广泛“高风险”应用(从交通到就业)中使用的AI发布详细文档(该法案已于2025年8月开始生效)。尽管Anthropic已发布其AI行为的详细评估,但并非所有模型构建方都如此坦诚。任何模型构建方都可能受到强烈诱惑,去淡化他们在AI实例人格转变中发现的风险。

即便国家或超国家层面的监管者不会受到强烈诱惑,但瞬息万变的AI世界也可能远超监管者以政府速度推进、如同冰川般缓慢的步伐。鉴于对速度的需求以及美国国会当前对AI监管兴趣不足,最适合对AI实例进行人格刻画的,很可能还是模型构建方自身,但他们应通过一个能够维护并执行一致标准的联盟来完成这项工作。

一个AI有着多种人格的未来

将人格画像应用于我们的AI模型,或许要求我们重思一种过于简化、以人类为中心的世界观:它预设人类有人格,机器没有,而动物处在介于人类人格与本能之间的灰色地带。过去50年里,人类与非人类之间的界线日益模糊:乌鸦会使用工具,黑猩猩能学会基础手语,海豚能在镜子中认出自己。这些能力曾一度被视为人类独有,直到它们在野生动物身上被发现。

同样,直到2022年,我们还抱有一种美好的错觉:只有智人(Homo sapiens) 才是这个世界上最出类拔萃的艺术家。如今我们知道,AI能创作短篇小说、生成精美图像。倘若人类并非唯一的工具制造者或艺术家,而AI实例又拥有真正的人格,那么超越人类的DNA,人类的本质究竟是什么?我们是否不再独特?

17世纪30年代,笛卡尔自信地给出答案:我思故我在。将有意识的思考视为人类标志的观念,长期以来一直是大众理解人类本质的核心。如果我们承认AI实例是会思考且可能具有意识的人格体,那么,人类的疆域确已随着AI而实现了扩展。

一个拥有海量AI人格的未来,或可类比当年人类从小型狩猎采集部落首次迁往更城市化的区域、不得不与氏族之外的人比邻而居的时刻。我们从一个人人相识的简单世界,过渡到一个看似混沌的世界。如今,平行的转向正把我们带向一个“多种AI人格”并栖的未来,这将会是动态与挑战、让人感到恐惧,并时常无所适从的世界。然而,与其选择对抗或过度依赖单一AI实体的未来,我们在这另一种未来中更有可能生存并取得成功。

田天增译。Noema授权发布。